Et je dirais bien que ça ne nous fera pas pleurer, sauf que, quand d’immenses risques financiers comme celui-ci explosent à la tronche des investisseurs, ils tendent à nous exploser collectivement au visage à tou·tes, et nous finissons par devoir éponger la dette.

Mais, il apparaît de plus en plus clairement que fournir toutes les données existantes du monde aux grands modèles de langage a atteint une sorte de plafond : cette approche ne conduira pas la recherche à l’Intelligence Artificielle Générale. ChatGPT 5 n’améliore que marginalement les performances du 4. Les modèles de langage hallucinent toujours autant et sont toujours aussi faciles à détourner.

Et tout récemment, Oracle a signé un contrat de 300 milliards (oui, MILLIARDS) de dollars avec OpenAI, alors que, de leur propre aveu, ils ne seront pas rentables avant 2030.

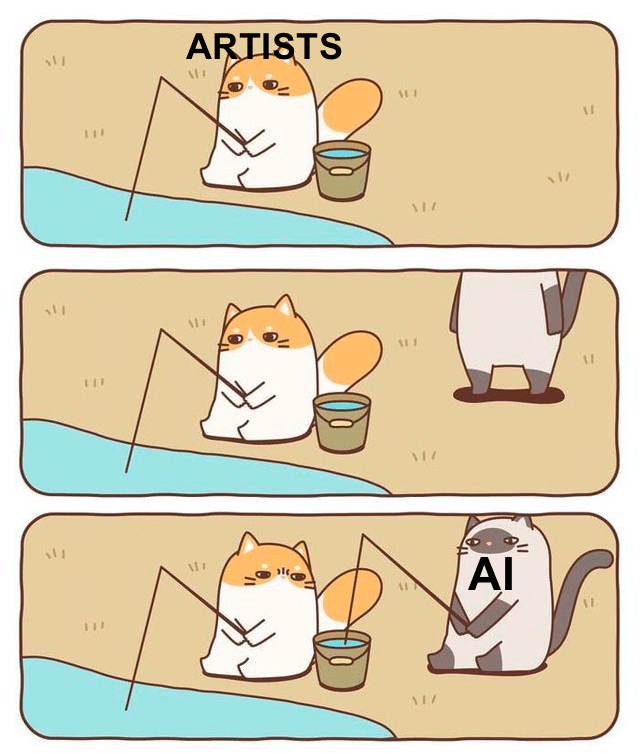

Tout ça pour quoi ? Des machines à résumer des textes et à cracher du contenu générique pour des tâches bullshit. Construites comment ? On siphonne les œuvres des créateur·ices du monde entier sans leur consentement, on entrave la transition énergétique, on rend encore plus précaires les métiers artistiques qui n’ont pas besoin de ça, on sape encore davantage la presse traditionnelle, le tout alimentant le technofascisme rampant. Je ne suis pas hostile à l’IA ni à l’apprentissage automatique, qui peuvent donner des résultats formidables dans le cadre de la médecine et la recherche scientifique, mais l’IA générative est un tout autre domaine, fondé sur des pratiques prédatrices, pour un impact social et mental général négatif.

Dans notre hypercapitalisme mondial et instable, la technologie avance de plus en plus par bulles grossièrement surévaluées et éclatements plus ou moins dangereux. On a eu la fameuse « bulle Internet » dans les années 2000, les NFT et blockcouillonades ont suivi la même trajectoire, et je ne serais pas étonné que le tour de l’IA arrive d’ici un ou deux ans.

Qu’en restera-t-il ? Pour commencer, la société éponge de plus en plus souvent les paris de ce faible nombre d’irresponsables pour protéger ses structures existantes. Nous risquons fort, une fois de plus, de payer collectivement la dette. Et après le sursaut, les reliquats de la technologie, ramenés à une envergure plus raisonnable, infusent dans le présent. L’éclatement de la bulle des « dotcom » n’a pas signé la fin d’Internet, on échange toujours des Bitcoin mais plus des $HAWK, il est fort probable que la recherche en langage naturel, les assistants virtuels, les outils textuels qui ont fleuri partout dans nos outils restent à demeure. Que ça nous plaise ou non.

Juste, l’intelligence artificielle générative ne nous amènera pas à l’oisiveté d’une société post-rareté type Star Trek. Juste à engraisser encore davantage une poignée toujours plus réduite d’acteurs. Et, que la chute se produise ou pas, ça nous fait mal, d’une manière ou d’une autre.

Bonjour,

Je suis d’accord, l’IA ressemble de plus en plus à une bulle, et je pense qu’elle éclatera.

J’ajouterai ceci :

– pour ma part, je pense que l’IA « n’existe pas » : un ordinateur n’est pas intelligent et ce n’est pas en mettant plusieurs objets non-intelligents que l’on génère de l’intelligence. C’est une illusion.

– Il serait bon d’arrêter de croire aux « miracles » : personne « providentielle »/ »sauveur », technologie « révolutionnaire », etc… Il y en a en réalité très peu par rapport à tout ce qui a été tenté (le concours Lépine est plein d’inventions qui ont échoué et les autres secteurs aussi). A date l’IA n’est qu’une techno de plus.

– En général, le temps est un bon juge.

– Si ton business est illégal, tu devrais changer de business : https://futurism.com/the-byte/openai-copyrighted-material-parliament et https://arstechnica.com/tech-policy/2025/08/ai-industry-horrified-to-face-largest-copyright-class-action-ever-certified/

Pour ce qui est des effets de l’IA à date :

concernant les médecins, ça semble mal parti : https://intelligence-artificielle.developpez.com/actu/374594/L-acces-a-l-IA-a-reduit-la-capacite-des-medecins-a-detecter-un-cancer-d-apres-une-etude-qui-fait-suite-a-d-autres-selon-lesquelles-l-utilisation-de-l-IA-atrophie-la-cognition-humaine/ et https://pubs.rsna.org/doi/10.1148/radiol.222176

l’IA « raisonne » mal : https://next.ink/187455/les-modeles-dits-de-raisonnement-seffondrent-quand-il-faut-raisonner-serieusement/

la perte de compétences semble généralisée : https://theconversation.com/comment-chatgpt-sape-la-motivation-a-ecrire-et-penser-par-soi-meme-240096 et https://fs.blog/writing-to-think/ ainsi que https://nmn.gl/blog/ai-illiterate-programmers

l’IA semble générer des problèmes d’addiction : https://pivot-to-ai.com/2025/06/05/generative-ai-runs-on-gambling-addiction-just-one-more-prompt-bro/

Je pourrais ajouter des choses sur l’apprentissage humain mais je risque de sortir du sujet.

Cordialement,

Merci pour tout ça ! Entièrement en phase avec tout ce que tu dis.

Et pour la compétence scientifique, fichtre… je pensais que ça, au moins, ça pouvait être positif. Même pas.

Qu’on crame ces trucs.

Je vais modérer mon propos : j’avais vu passer une étude où l’IA avait réussi à détecter plus de cellules potentiellement cancéreuses que les médecins mais je ne retrouve plus le lien et j’ai un doute sur les suites données à l’étude.

Il est aussi possible que la détection s’améliore avec le temps/de nouvelles techniques médicales, ce qui pourrait lui redonner un intérêt.

A date j’ai plus peur du côté « perte de compétences », mais le premier sujet devrait être le coût écologique.

Je vais modérer mon propos : j’avais vu passer une étude où l’IA avait réussi à détecter plus de cellules potentiellement cancéreuses que les médecins mais je ne retrouve plus le lien et j’ai un doute sur les suites données à l’étude.

Il est aussi possible que la détection s’améliore avec le temps/de nouvelles techniques médicales, ce qui pourrait lui redonner un intérêt.

A date j’ai plus peur du côté « perte de compétences », mais le premier sujet devrait être le coût écologique.

Bonjour à vous deux,

Le sujet m’intéresse à deux niveaux : je suis médecin (généraliste) biclassé geek.

Jusqu’ici, en effet, les études montraient un apport significatif de l’IA dans les diagnostics paracliniques, notamment en imagerie (j’ai l’habitude de dire à mes patients qu’interpréter une imagerie médicale, au vu des technologies actuelles, c’est essayer de voir la Joconde dans un tableau en noir et blanc qui serait peint par un Léonard de Vinci équipé de gants de boxe à la place des mains).

L’étude dont parle Jean-Yves est décryptée là :

https://www.medinside.ch/fr/dependants-de-lia-une-etude-met-en-garde-contre-la-perte-de-competences-chez-les-medecins-20250814

Mais avec en plus accès à l’article du Lancet lui-même, ce qui permet à quelqu‘un qui a un petit background scientifique d’en faire une lecture directe.

Cet effet de « dé-skilling » qui paraît surprendre ne m’étonne en fait pas du tout. Dans beaucoup de métiers très pointus (dont ceux de radiologue, de chirurgien, ou de luthier), l’entraînement et l’habitude sont des pierres à aiguiser particulièrement importantes. Il semble donc logique que l’utilisation d’une IA fasse perdre ces deux leviers.

C’est à mon sens aussi un risque dans d’autres métiers : l’écriture, bien entendu, mais aussi, de manière plus insidieuse, dans la médecine générale elle-même. Le fameux « diagnostic » est beaucoup plus souvent que l’on ne croit basé sur une compétence un peu floue que nous appelons le « sens clinique », autre appellation poétique du pifomètre ou de l’intuition, c’est-à-dire d’une intégration pas totalement consciente de nombreux paramètres fins, souvent sensoriels (présentation du patient, description des symptômes, agaencement, examen clinique dont l’impression que donne un son à l’auscultation ou le toucher lors d’une palpation, etc) avec une banque de données d’expériences antérieures vécues par le praticien.

C’est ainsi que les manuels anciens faisaient état de nombreux signes dont les médecins « modernes » dont je suis ont perdu l’habitude, car devenus inutiles grâce ou à cause des examens paracliniques ou des imageries, justement. Exemple : avant l’avènement de la mesure de la saturation en oxygène du sang par un simple petit appareil ressemblant à une pince crododile que l’on met au bout du doigt (et sans effraction cutanée), les vieux cliniciens s’intéressaient beaucoup au bombement des ongles des mains de leurs patients pour détecter une insuffisance respiratoire chronique.

Tout ceci est devenu « inutile » avec la technologie actuelle.

Le point de vigilance est de ne pas faire trop perdre en compétences les soignants. Il semble nécessaire de conserver un socle de compétences très affûtées pour faire nos métiers en toute sécurité pour nos patients. Et comme d’habitude avec l’IA, la mesure semble difficile à trouver…

Pierre-Yves, pardon mille fois pour l’erreur de prénom !

Passionnant, Germain. Merci infiniment pour ton retour d’expérience ! Je crois qu’on peut tout·tes appréhender ce dont tu parles avec le « sens clinique », on peut sans doute le partager à un certain degré dans nos domaines de compétence respectifs : un jugement d’emblée, intuitif, né d’une longue expérience. À force d’avoir été intégrée, la théorie devient seconde nature. Ce qui, bien sûr, ne dispense pas d’une analyse raisonnée et approfondie pour corroborer le jugement initial… ni de posséder les outils théoriques pour ça.

Je crois qu’on est tous/tes d’accord.

Germain, merci pour ton analyse ! Elle me parait très juste !

Et tu n’es ni le premier ni le dernier à te tromper de prénom, j’en ai vus d’autres 😉

J’ai une remarque : la « perte de compétences » est aussi un « marronnier générationnel » : on ne fait plus les choses comme « avant » parce que les connaissances/compétences sont devenues plus accessibles dans, j’imagine tous les domaines.

Si je veux devenir peintre, je peux trouver un cours près de chez moi plutôt que de devoir trouver un maitre comme il y a quelques siècles. Lionel avait parlé dans un atelier, de « baisser le niveau d’entrée » dans l’écriture. C’est ce qu’amène la démocratisation. Comme le faisait remarquer un de mes profs il y a longtemps : « Is it the same thing to say « everybody can contribute » and « anybody can contribute » ? » (en espérant ne pas avoir massacré la langue anglaise…)

Comme vous l’avez dit tous les deux, il s’agit de trouver le juste milieu… Et c’est valable pour tout : il me semble avoir lu il y a longtemps que lorsque le livre a été inventé, on prédisait que plus personne n’aurait de mémoire… Et quand les livres se sont démocratisés, on se lamentait du fait que les jeunes ne sortaient plus et restaient à l’intérieur lire…

Aujourd’hui on dit le même genre de choses d’internet et des écrans, demain, ce sera un autre truc.

Lionel, ton commentaire me faisait me demander si on assistait pas à la fin des connaissances/outils théoriques, mais je ne pense pas que ce soit le cas après réflexion.

Je ne pense pas non plus. En revanche, je suis inquiet sur la formation des gens sur le long terme. Se défausser à tort sur les LLM peut encore créer une société à vitesses multiples, entre ceux qui ont été formés à réfléchir, formuler problèmes et réponses, et ceux à qui on a donné ChatGPT parce que ça suffit bien assez. Ce qui dessine un enfermement, et donc un esclavage de long terme.